作者:全月

上个月,联合国在特定常规武器公约会议上发布了一段“杀人机器人”视频,强烈呼吁AI技术巨大的危害和道德风险,引发热议。视频中,类似杀人蜂的小型人工智能机器人通过面部识别系统辨别射杀对象,迅速敏捷将其击毙。

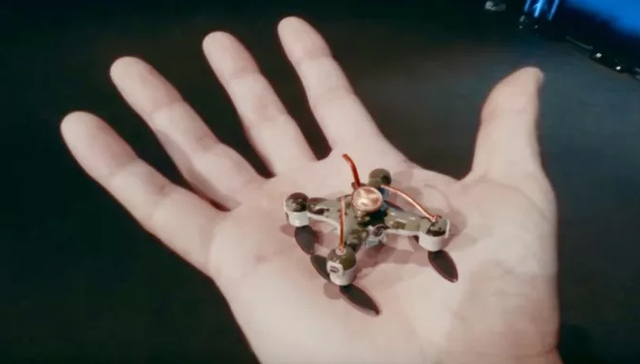

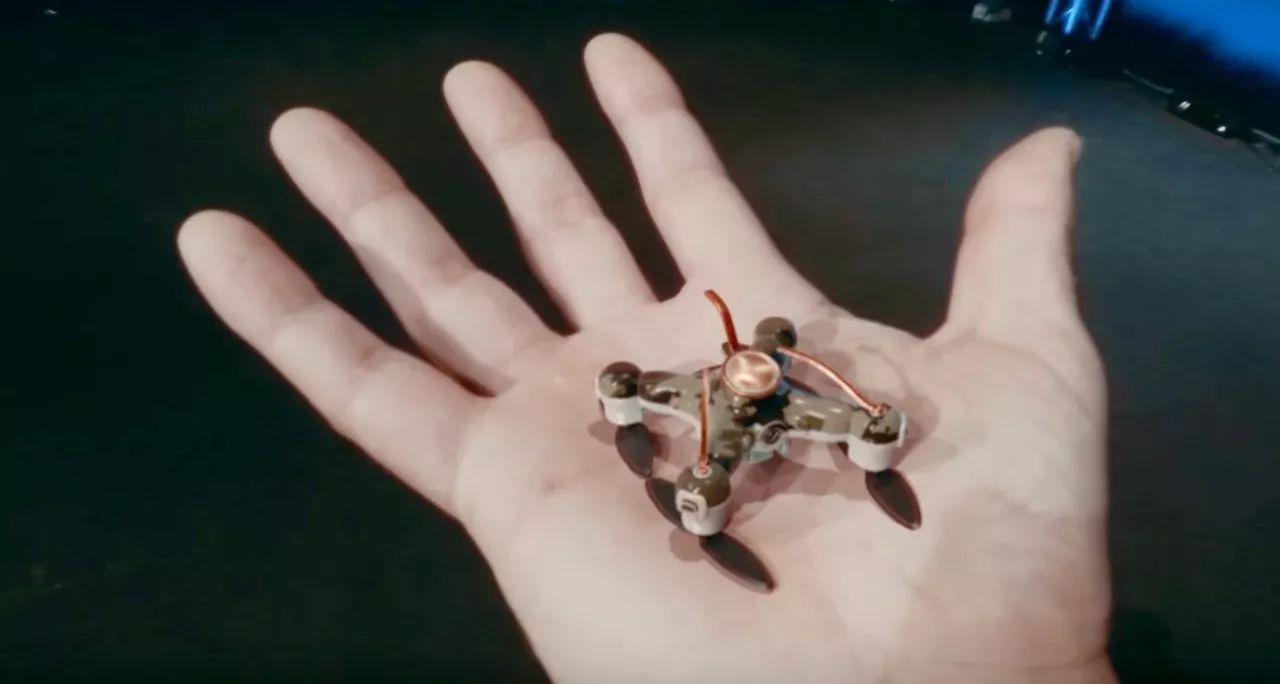

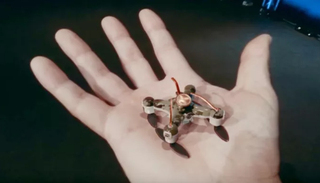

这款所谓的“杀人机器人”,体型大概蜜蜂大小,飞入会场后躲过演讲人的抓捕,导航系统完全基于 AI 。

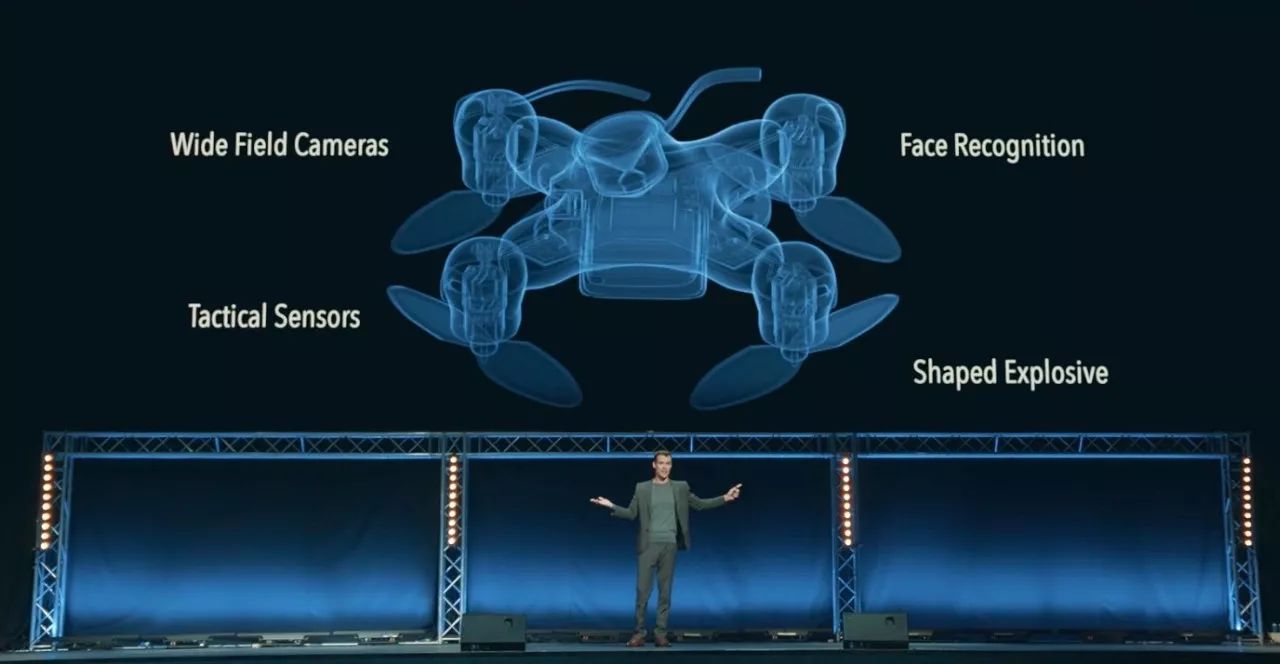

从具体的配置上看,这个机器人配有:广角摄像头、战术传感器、面部识别技术,并且在其内装有3克炸药。

下图展示了机器人使用人脸识别技术,结合导航,攻击目标。

精准打击,足以穿透头骨。

视频最后还演示了一段飞行机器人集体攻击人类的画面,通过面部识别定位,轻易杀死了正在上课的一班学生。

2016年7月,美国达拉斯警方在拆弹机器人上安装炸药,远程操控该机器人行至一名嫌疑犯躲藏地点并引爆炸弹,嫌犯当场死亡。美国达拉斯警方“创新”使用拆弹机器人将枪击嫌疑人炸死的事件引发了很多争论。

如果说当时还是“使用(其他用途)机器人去杀人”,那么这次就是真真正正制造“杀人机器人”。

在视频结尾,伯克利的Stuart Russell发出警告称,尽管视频中的杀人机器人只是一个展示,但相关技术已经存在。要避免视频中的悲剧发生,我们需要尽快行动。

关于杀人机器人的争论,实际上一直存在

1942年,艾萨克·阿西莫夫(Isaac Asimov)发表了一个名为“Runaround”的短篇小说,创造了“机器人”一词,并引入了机器人杀死人类的想法,只要我们能够制造机器人,我们一直担心他们杀了我们。

自阿西莫夫以来,自治机器人系统确实走过了漫长的道路。2012年,人权观察组织发表了一份报告,提出杀手机器人是一个机器人,可以决定在没有人为干预的情况下使用致命的力量,这个定义随后被扩大到包括任何可以选择对人类使用武力的机器人,即使这种武力不是致命的。报告的标题是“失去人性:杀人的机器人”。

2017年8月,全球100多位AI先驱呼吁联合国禁止杀手机器人的开发和使用,特斯拉的Elon Musk和DeepMind联合创始人穆斯塔法·苏莱曼(Mustafa Suleyman)也在其中。这份公开信警告说,必须紧急禁止在火药和核武器之后进行“第三次战争革命”。到目前为止,已有19个国家要求禁止,包括阿根廷,埃及和巴基斯坦。

11月,在日内瓦举办的联合国特定常规武器公约会议上,文章开头提到的那段骇人听闻的视频发布,视频中类似杀人蜂的小型人工智能机器人通过面部识别系统辨别射杀对象,迅速敏捷将其击毙。至此,关于杀人机器人的讨论空前。

值得注意的是,视频制作的相关研究人员此举引发的震惊恐吓形成的轰动效应需要谨慎对待,特别是当目标不是传达事实,而是利用情感和恐惧的时候,其传播效果已被证明足够有效。但是,这样的视频,由学者创造和推广,可能会使公众更加怀疑和恐惧机器人,这是机器人界长期以来竭力避免的。人工智能和武器控制专家们仍然在讨论,哪些领域、产品特别应该受到管制或禁止,以及如何执行。

军用机器人趋势不可逆,冰冷机器无法权衡道德后果

军事应用中将会使用更多人工智能机器人,这是不可逆的趋势,它们有能力执行更多困难的任务。在要求速度和精度的情况下,军用机器人的神经网络的机器图像分类器已经能够在一些基准图像识别测试中击败人类。

这些优势表明,在战争中的某些情况下,机器可能会胜过人类,比如迅速确定一个人是否持有武器。机器还可以追踪人体的动作,甚至可以捕捉潜在的可疑活动,比如一个人可能是一个隐藏了武器,这类反应比人类更快,更可靠。

机器智能目前有许多弱点,神经网络容易受到网络的欺骗攻击(发送虚假数据),伪造“愚弄的图像”可以用来操纵图像分类系统,使其相信一个图像是另一个图像,并具有非常高的置信度。而且,这些图像可以以一种人类无法察觉的方式隐藏在普通图像中。攻击者不需要知道神经网络为了欺骗网络而使用的源代码或训练数据,这使得这些系统的真实应用程序成为一个令人担忧的漏洞。

更普遍的是,今天的机器智能是脆弱的,缺乏人类智能的稳健性和灵活性。即使是一些最令人印象深刻的机器学习系统,如DeepMind的AlphaGo,在玩不同尺寸的棋盘时,其性能明显下降。

人类也能够理解战争的道德后果,战争中的许多决定都没有简单的答案,需要权衡,机器无法衡量人类的生命价值。美国参谋长联席会议副主席保罗·塞尔瓦(Paul Selva)在今年7月份向参议院军事委员会表示:“我们认为让机器人负责我们的生命是不合理的。”

在对自主武器发展是否应适当介入人类控制的复杂讨论中,必须充分考虑快速发展的地空自主系统商业市场。考虑到商业领域可以提供衍生或优越的技术,禁止使用自主技术用于军事用途可能并不现实。

俄罗斯态度强硬,坚持建造杀人机器人

11月初在日内瓦举行的联合国致命自主武器系统会议上,俄罗斯对联合国提议的禁止致命自主武器系统(LAWS)采取强硬态度,表示无论如何都会造成杀人的僵尸。禁令旨在防止任何先进的AI计划在战场上杀死平民和人员部队。但俄罗斯高层官员表示,全面禁止将阻止科技公司开发可使数百万人受益的民用AI系统。政府发言人说:“俄罗斯联邦认为,这种武器系统的工作样本的缺乏仍然是在法律讨论的主要问题。

尽管联合国会议的目的是建立一个禁止完全自治的“杀手机器人”的框架,但是俄罗斯拒绝接受禁令甚至抵触这个议题的任何形式的监管,引发了多方的讨论,对会议形成共识造成了严重阻碍。

美国和其他西方列强指责俄国准备违反未来的交易,使用杀手机器人对自己的士兵,他们指出超级大国以前违反核武条约,迫使美国发展新型地面巡航导弹。

与此同时,英国官员警告说,大量的杀手机器人可能被用来对其公民发动致命的攻击。艾尔·波芬诺埃尔·夏基(Simon Noel Sharkey)对恐怖分子可能使用杀人无人机在英国进行毁灭性的暴行做出了令人不寒而栗的预测。停止杀手机器人运动的发言人随后警告说,致命的技术在不法分子手中清盘的后果将导致灾难性的后果。

早在今年7月,俄罗斯武器制造商卡拉什尼科夫(Kalashnikov)宣布将推出一系列自主作战无人机,这些无人机将使用人工智能来确定目标并自行作出决定。 该公司发布了其中一个作战机器人的图像,显示它将有一些卡拉什尼科夫的PK系列机枪安装在上面。 目前尚不清楚机器何时投入生产,或者是否有客户已经有兴趣部署。