近日,斯坦福大学发表的一篇新论文中指出:计算机算法可以拥有比人类更为敏锐的识别性取向的“同性恋雷达”。然而此项研究成果引发了一系列关于性取向的生物决定因素、人脸识别技术和软件侵犯人类隐私等问题的争议。

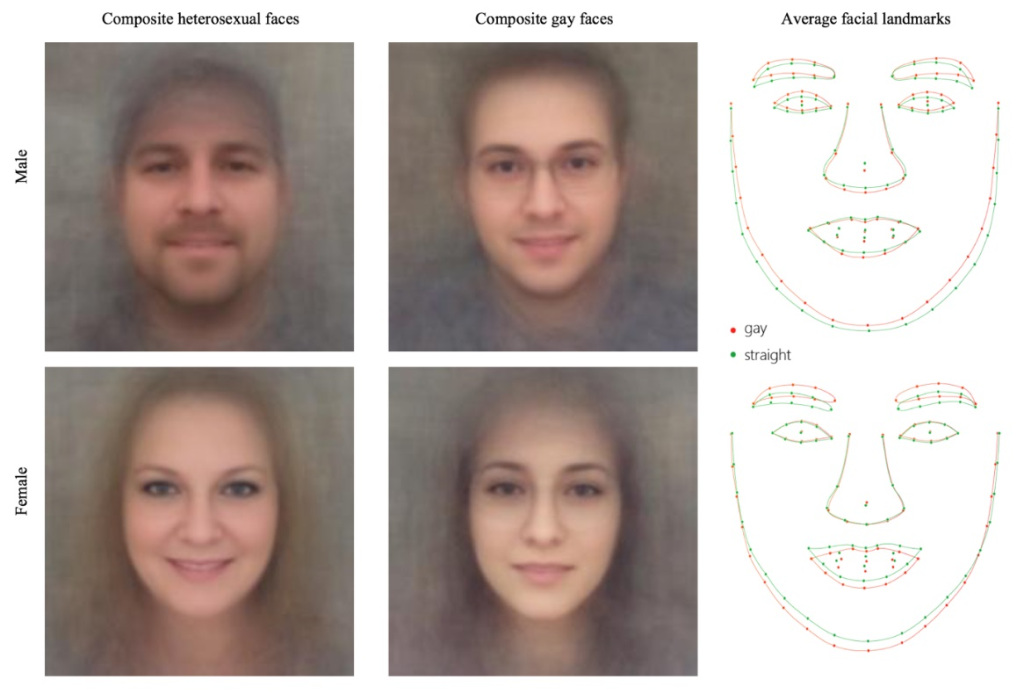

研究发现,男女同性恋倾向于具有“非典型性别特征”,也就是说男同性恋通常趋向于女性化,而女同性恋反之亦然。此外,研究人员发现男同性恋通常拥有比直男更窄的下巴、更长的鼻子以及更大的前额,而女同性恋会拥有更大的下巴和更小的前额。

论文还指出,研究结果为“性取向源于出生前受某些激素影响”这一观点提供了强有力的支持,即性取向是“天生的”,而非后天自我选择的结果。而机器对于女性性取向识别成功率较低的现象则证明女性对于性取向更加灵活。

这篇发表在《人格与社会心理学期刊》上的论文名为《深度神经网络能比人类更准确地通过面部照片判断性取向》。作者Michal Kosinski与Yilun Wang利用深度神经网络从超过3.5万张美国交友网站上的男女图像中提取特征,利用大量数据让计算机学会了识别人们的性取向。

随后的实验成果显示:计算机算法仅凭一张照片区分直男与同性恋的准确率高达81%,对女性的性取向判断准确率为71%。而人类对性取向的敏锐程度就差得多:男女同性恋的判断准确率分别仅为61%和54%。如果可以看到同一人的五张照片,那么计算机对男女性取向的判断准确率还将进一步提高至91%和83%。

研究人员在论文中得出结论称:面部表情实际上包含着许多人脑没有摄取到的性取向信息。

值得注意的是,此项研究的局限性十分明显:有色人种,跨性别者和双性恋都没有被纳入考量。

此外,研究人员警告称,存储在社交网络和政府数据库中的数十亿公共数据将有可能在未获得本人许可的情况下被用来进行性取向识别。夫妻一方可以借此调查自己是否被骗婚,青少年会用这种算法来识别自己或同龄人。而在同性恋不合法的国家,这种算法更有可能造成危害他人安全的结果。

面对这些争议,研究人员表示,相关技术已经存在,公开结果的目的是为了政府和公司更加慎重地考虑,并制定法规加以约束。

作者写道:“我们相信对隐私的侵犯已不可避免。但保障同性恋和其他少数群体安全的关键不在于隐私权,而在于人权,以及社会与政府的容忍程度。一个更为安全和友好的后隐私世界应当被那些受过良好教育的人所主导,他们不会包容那些没有包容心的行为。”

多伦多大学心理学副教授Nick Rule表示:“这当然是令人不安的,它就像任何新工具一样,如果被错误地使用,就会造成危险。如果我们开始以外表来判定人的好坏并作出一些伤害他人的事,那可真是太糟糕了。”

不过Rule肯定了此项研究的价值:“研究人员证明了这种方法非常强大……现在我们明白我们确实需要得到一些保护。”

论文作者同时指出,AI(人工智能)可以被用于探索面部特征与其他很多特性之间的联系,如政治观点、心理状况和个性。在去年的美国大选和英国脱欧公投时期,数据分析机构也使用了类似的分析方法来锁定目标选民。

《卫报》分析指出,这一类型的研究意味着科幻电影《少数派报告》所描述的场景有望成真:在电影中,警察可以逮捕那些“仅仅是被预测有可能犯罪”的人。

人脸识别科技公司Kairos的首席执行官Brian Brackeen肯定了斯坦福大学的研究。他认为人们需要对于隐私和机器学习新技术持有更加慎重的态度来阻止危险发生。他同时还表示:“如果有了足够的数据,AI可以告诉你任何人的任何事。可是是对于社会来说,我们需要知道这些吗?”